Veri okuryazarlığı nasıl olur, neden gerekli?

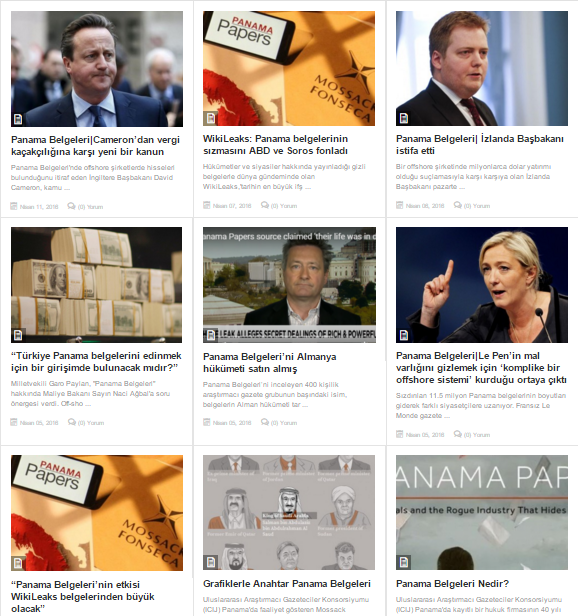

Önce ‘Wikileaks’, ardından ‘Panama Papers’ ile milyonlarca belge sızdırıldı. Panama Belgeleri’nin haberleştirilmesi için dünya çapında 400’e yakın gazeteci ‘veri gazeteciliği’ yaptı. Peki veri gazeteciliği aslında ne demek, kullanılan araçlar ne, gazeteciliğin tanımı mı değişiyor, sızdırılmış veriler gazetecilik pratiğini nasıl etkiliyor ve daha önemlisi Türkiye’de veri gazeteciliği yapılıyor mu? Tüm bu soruları Pınar Dağ’a sorduk.

Gülin Küpelioğlu /journo.com.tr

Kaynak: http://journo.com.tr/pinar-dag-veri-sizi-daha-iyi-bir-gazeteci-yapar

Sızıntıların önem kazandığı böylesi bir dönemde veri gazeteciliği nasıl bir tanımla karşımıza çıkıyor. Ne demektir veri gazeteciliği ve kime veri gazetecisi denir?

Veri ile gazetecilik alternatif bir habercilik modeli olarak karşımıza çıkıyor. Birçok tanımı ama tek bir amacı var: Daha etkin habercilik yapmak. Bilgisayar destekli gazetecilik (Computer- assisted reporting), veri güdümlü gazetecilik (Data Driven Journalism), yapılandırılmış gazetecilik (Structured Journalism), excel gazeteciliği (Excel Journalism) gibi terminolojik bir kronolojisi de var. Veri Gazeteciliği El Kitabı’nda (Data Journalism Handbook) yapılan tanımında ise, ‘veri ile gazetecilik yapmak’ olarak yer alıyor. Şahsen yürütttüğüm faaliyetlerde, derslerimde, uygulama alanı bulduğum her ortamda şahsi tanımım da bu yönde.

Yapılan her türlü gazetecilik faaliyetinde veriyi organize edip, filtreleyip günümüz dünyası için anlamlı hale getirmek ve bunun için bazı hünerlere sahip olmaktır. Bu hünerler veriyi analiz etmek ve filtrelemek, veriye ulaşımın sınırlı olduğu durumlarda veri kazıma imkanlarından yararlanabilmek (data miner, e-tabloya webden veri aktarmak) dağınık veri ile başa çıkabilme yeteneğine sahip olmak (open refine kullanımı), veri setini özetleyebilen yetkinliğe sahip olmak (çevrim içi özet tablo/pivot tablo kullanımı), web tabanlı e-tablolarda zaman geçirmek (spreadsheet vb.), interaktif araçları etkin ve doğru kullanmak, temel istatistik bilgilerine sahip olmak, veri ile söyleşi yapmak ve haberde kullanılacak her türlü veri gazeteciliği (Data Journalism) aracının veri seti ile uygunluğunu bilmek (örneğin coğrafi veri seti için hangi araç kullanılmalı, çubuk grafiğin alternatifi nedir, nüfus grafiği hangi tür veri setinde kullanılır gibi) ve bu süreçte normal dağılımın ne olduğunu iyi anlamak ve en önemlisi veri toplama, doğrulama ve veriyi araştırma tekniklerini pratikleştirmek.

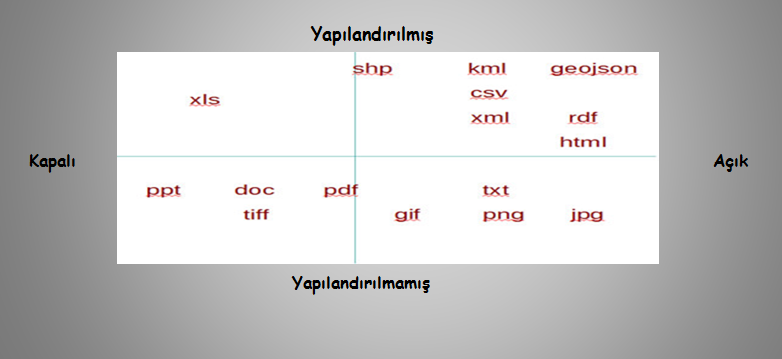

Veri gazetecisi (Data Journalist) ihtiyacı olan veri seti format tipini önemsemek durumunda ve tabii ki teknik bazı önemli detayları da anlamakla sorumlu. Yapılandırılmamış bir dosyadan bilgi toplama süreci (Taşınabilir Belge Tipi /Portable Document Format (PDF) gibi ) zaman kaybettirirken, taşınması kolay, araçlarla uyumlu (Virgülle Ayrılmış Değerle/Comma-separated values(CSV) dosya tipine ulaşmak ve kullanmak bu alanda çalışanlar için giderek daha fazla önem taşıyor. Örnek üzerinden gidilirse; neden standart bir e-tablo oluşturma formatı olan CSV önemli, çünkü çok basit bir açık formattır ve kullanımı çok kolaydır, genellikle açık verileri yayımlamak için kullanılır.

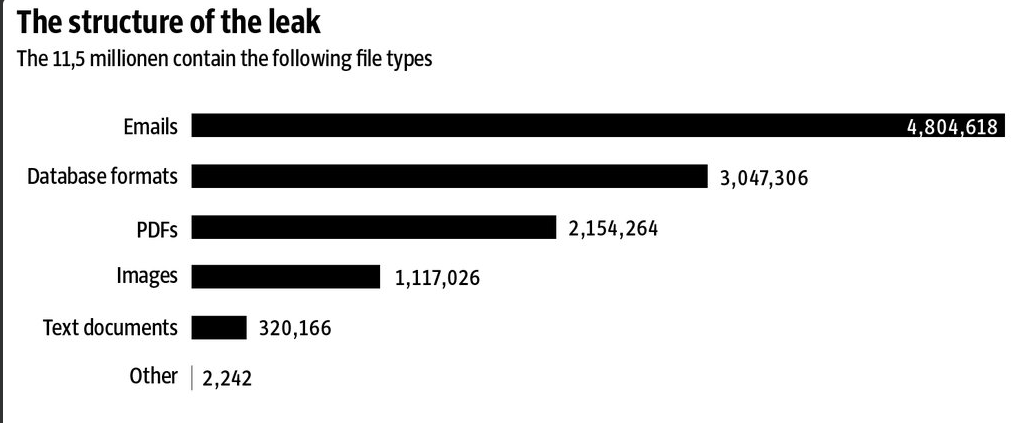

Veri gazeteciliği kamu yararını gözeten, hayat kalitesini arttıran, hesap verebilirlik ve şeffaflık konularıyla doğrudan ilgili olan bir daldır ve sızdırılmış veriler bu alanın gelişmesinde önem arz ediyor. Wikileaks sonrası yazılan el kitabı, Swissleaks /Luxleaks kardeş sızıntıların dünya gündeminde giderek önem kazanması, ‘Veri Gazeteciliği 2015 Ödülleri’ni alması, henüz tam olarak göremediğimizPanama Belgeleri’nin gündemi sarsan gücü ve yürütülen faaliyetlerin tümünün veri gazeteciliği teknolojileri ve çözümleri ile şekilleniyor olması, Panama Belgeleri’nin de 2016 Veri Gazeteciliği Ödülleri’ne aday olması bu alanın açık, ham, sızdırılmış verilerden beslendiği gerçeğini pekiştiriyor. Bu sebeple veri gazetecilerinin işi veri yığınlarını analiz edebilecek pratikler ve teknolojiler kullanarak onları anlamlı hale getirmek. Bu bazen 11,5 milyon yarı yapılandırılmış belge de olabilir.

Açık veri ne demek? Veri gazeteciliği için ne önemi var?

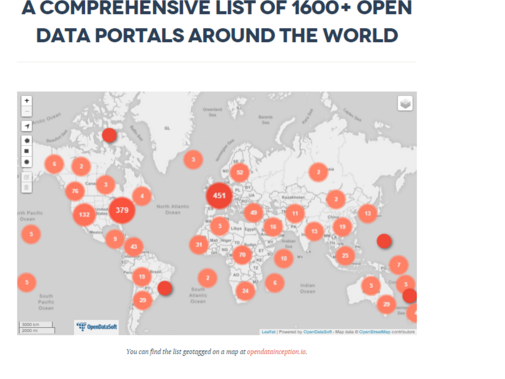

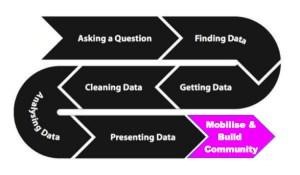

Açık veri (Open Data) yolsuzlukla mücadelede etkin bir araç. Tanım vermek gerekir iseOpenDefinition.org açık veri tanımı yaparken şöyle diyor: “Herhangi bir telif hakkı, patent ya da diğer kontrol mekanizmalarına tabi olmaksızın herkes tarafından ücretsiz ve özgürce kullanılabilen, tekrar kullanılabilen ve dağıtılabilen bilgi” ve devamında da “Açık bilgi; açık verinin erişilebilir, anlaşılabilir, anlamlı ve birinin gerçek sorununu çözmeye yardımcı olmasıdır” diyor.

‘Birinin gerçek sorununu çözmek’ burada kilit cümle konumunda, açık veri politikasının gelişmesi istihdam yaratıyor, depremlere, sel felaketine yönelik önlem almanızı sağlıyor ve hastalık teşhisi öngörüsünde özellikle az gelişmiş toplumlarda etkin bir hayat kurtarma aracına dönüşüyor. Hem modern gazetecilik faaliyetlerinde hem hayatın her alanına verilerin kurumlar, devletler tarafından teknik ve istenen şekilde erişime açılması dünyayı değiştiriyor.

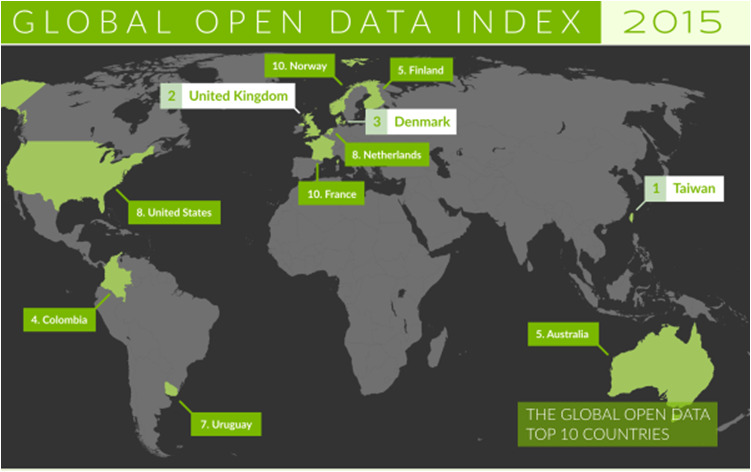

Veriye ulaşımınızda teknik ve yasal sorunlar yaşamıyorsanız daha etkin veri gazeteciliği yapabilirsiniz ki her yıl verilen veri gazeteciliği ödüllerinde açık veri kategorisi bu sebeple önem kazanıyor. Açık veri eşittir güçlü, ölçülebilir, analiz edilebilir, karşılaştırma yapılabilir haber üretmedir ki bu da etkin veri gazeteciliği yapmayı sağlar. Bu sebeple temel verilerin kullanıcıya istenen formatta sunulması da açıklık konusunda önem kazanır. Faaliyetleriniz ile ilgili tuttuğunuz bilgilere sadece sitenizde öylece yer vermeniz yeterli olmuyor, onları yapılandırmanız, çağın her türlü aracına uyumlu programlama dilleri ile konuşabilen bir perspektife sahip olmasını sağlamanız gerekiyor. Veri gazeteciliği alanını geliştiren ve böylesi bir tanımla karşımıza çıkartan unsurlardan biri de zaten devletlerin kamusal verilerini herkesin kullanımına açması, veri tabanlarına erişim kolaylaşması. (Açık Devlet Örneği)

Verinin açık olmasının, rahat ulaşabilmemizin, analiz etmemizin yanı sıra olayları önlemek, önlem almak gibi kıymetli bir tarafı var. “Açık veri hayat kurtarır” dendiğinde, “veri candır” dendiğinde aklımızda bir şeyler belirmeli neden hayat kurtardığını, nasıl kurtardığını anlamamız gerekiyor.

Gazetecilik açısından bakıldığında veri ile çalışmak neden önemli? Bir veri haber merkezlerinde nasıl habere dönüştürülüyor?

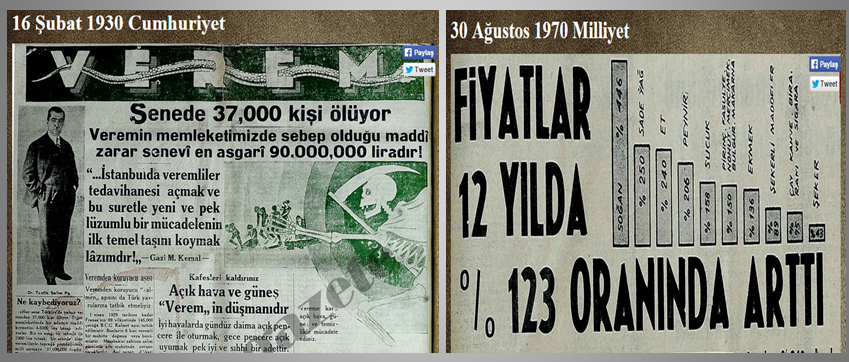

Veri ile çalışmak her zaman önemliydi, yeni bir şey değil esasen. Belki şu anda neden bu kadar önem kazandı, buna yanıt aramak gerekiyor. Veri ile gazetecilik yapmak sizi daha iyi bir gazeteci yapar. Çağ ve teknoloji ile uyum bir gazeteci için önemli.

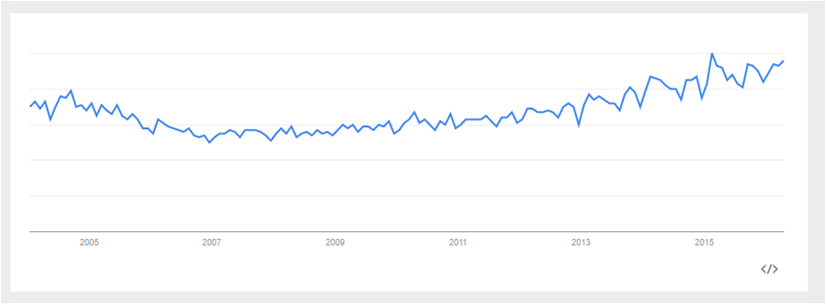

Çevrim içi araçlara erişimin kolaylaşması, çok büyük teknik bilgi gerekmeden kolayca etkileşimli haritalar, grafikler ve görsellerin yapılmasını sağlayan araçların artması, devletlerin kamusal verilerini herkesin kullanımına açması, veritabanlarına erişimin kolaylaşması, doğruluğuna emin olunan verilerin haberlerde kullanılması; daha fazla şeffaflık sağlayarak gazeteciyle okuyucu arasında güven sağlaması ve farklı meslek gruplarının dahil olması, haberciliğin alet çantasına yeni araçlar ve meslek disiplinlerinin ekleniyor olması, veri denetimine veriyi doğrulayan, istatistikçi, veri bilimci, yazılımcı, tasarımcı gibi daha fazla alandan meslekler transfer edebiliyor olması bu alanın önemli olduğunu ve önemli hale geldiğini kanıtlıyor. Şu andaki önemi ise tabii ki İnternet’e erişimin genişliyor ve artıyor olması. İlerleyen yıllarda böyle bir tanım bile kalmayabilir. Çünkü veri ile daha etkin çalışmak giderek kolaylaşmaya ve yaygınlaşmaya başlayacak. Olağanlaşacak ve bir alternatif olmaktan çıkacak. Çıkıyor da şu anda.

Gazeteciliğin tanımı değişiyor mu? Artık bir haberi yaparken 5N1K yeterli değil mi?

Tabii ki değişmiyor, gazetecilik gazeteciliktir. Çağ ve teknolojiyle, İnternet erişiminin yaygınlaşmasıyla modeli değişiyor ancak temel disiplini ve motivasyonu hep aynı. Veri gazeteciliği sürecinde 5N+1K’yı yanıtlarken sadece şöyle bir yol izliyorsunuz ancak hikâye her zaman önemli ve veri gazeteciliğini de haberden daha etkin yarar sağlamak için yapıyorsunuz.

Türkiye medyasındaki gazetecilik kültürü veri gazeteciliğinin detaylı ve zaman alan pratiğine ne kadar uygun?

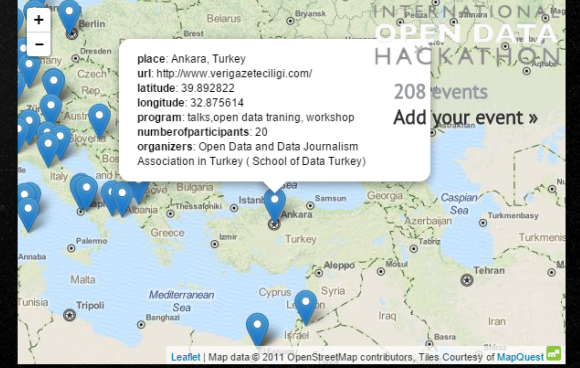

Hakim iklimde gazeteciliği kurtarmak için seferber olanlar ve karşısında hedef gösteren, parti sözcüsü olmuş, halkla ilişkiler şirketi olarak faaliyet yürüten ama bunu da gazetecilik çatısı altında yaparak geçinen nitelikten, derinlikten, etikten yoksun bir yapı var. Bunun üzerinden bir değerlendirme yapmam gerçekçi olmayacağından genel bir yanıt vermeye çalışacağım. Araştırmacı gazetecilik, soruşturmacı gazetecilik eşittir açık/veri gazeteciliği. Bu tür habercilik modelleri bütçe isteyen, zamana ihtiyaç duyulan, iyi bir ekip gerektiren, kendi gündemi olan, uzun soluklu çalışma şekliyle mümkün olabiliyor. Ancak veriyi son dakika haberciliğinde kullanmak ve doğrulamak, sıcak haber trafiğinde veri ile gazetecilik yapmak önemsenen bir durum. Geçen yıl Veri Gazetecisi Eva Contantaras’ı bir atölyeme davet etmiştim, kendisi bu yönde bir sunum da paylaşmıştı. Sunumuna buradan ulaşabilirsiniz.

Türkiye özelinde veri ile ilişkimiz bu bağlamda henüz güçlü değil. Bugün yürüttüğümüz faaliyetler açısından Türkiye, bazı ülkelerin ilerisinde görünebiliyor. Ancak pratikte henüz güçlü somut bir dönüşüm yarattığını söylemek mümkün değil.

Neden böyle düşünüyorsunuz?

Üretimin yetersizliği, dünya örnekleri ile kıyaslama zeminin mümkün olması, günceli takip ediyor olmam. Zaten veri ile ilişkimizi sadece gazetecilik değil, diğer konular üzerinden de okuyabiliriz. Veriye erişim ve veriyi erişilir yapma politikalarının zayıflığı da bunu gösteriyor.

Veri okuryazarlığı nasıl olur, neden gerekli?

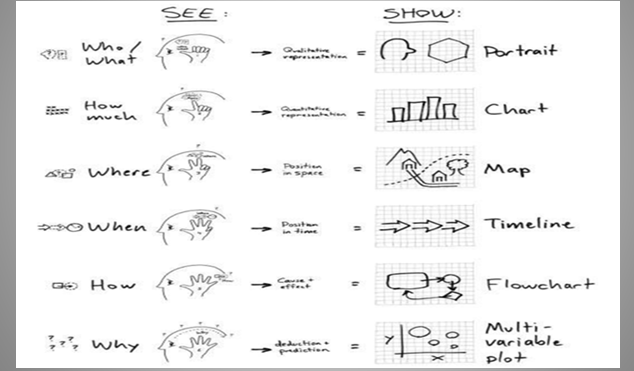

Veri okuryazarlığı bu başlık altında çok yaygın değil henüz. Öncelikli olarak nasıl tanımlanıyor, öncesinde başka bir kavram çatısı altında mıydı bunu bilmek gerekli olabilir. ‘Aritmetik Okuryazarlık ve Bilgi Okuryazarlığı’ (Numeracy&Information Literacy) tanımı üzerinden şekillendiğini belirtebiliriz ve şu anki ismi üzerinden ise, ‘veriyi kullanabilme ve analiz edebilme yeteneği’ tanımını alıyor.

Bu alanda örnekleri analiz eden araştırmacılar ise veri okuryazarlığını şöyle tanımlıyorlar; veriyi okuyan, analiz eden, veri kullanma yeteneği olan ve pratiklerini, çalışmalarını veri ile temellendiren yani veri ile konuşabilen ve tabii ki aynı zamanda içinde bulunduğu sosyal yapının içine veri ile girebilme yeteneği olan, bunun üzerinden okumalar yapabilen.

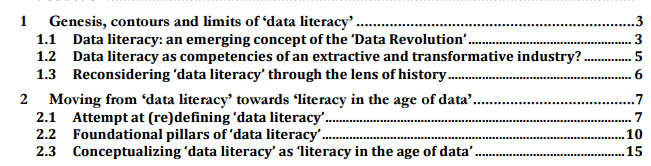

Verdiğim kaynaklar üzerinden kendi değerlendirmem ve tanımım ise pek farklı değil, veri ile söyleşmek, veriden bilgi çıkarabilme yeteneği, bir verinin iyi ya da kötü olduğunu anlamak, filtreleyip, analiz edip, özetleyebilmek ve yaptığınız çalışmalarda etkin şekilde kullanabilip kamuyla etkileşime geçmeyi başarmak tüm bu tanımın başlığı altında yer alıyor. School of Data’nın Defining Data Literacybaşlıklı yakın tarihte yaptığı bir çalışmada veri ile çalışan ve çalışmayan kişilere, ‘Veri Okuryazarlığı’ nedir kapsamında sorular yönelterek, analiz yapılmış.

Bazı çıktıları şöyle:

- Bilgiye, veriye farklı yollardan nasıl ulaşılacağını bilmek

- Veriye soru sorabilmek ve yanıt alabilmek

- Veride spesifik çıktılar bulabilmek (bir hikaye, görselleştirme gibi)

- Veriyi kişinin kendi kişisel çalışma alanı, hedefleri için kullanabileceği bir güce dönüştürmeyi başarabilmesi

- Veri ile çalışırken rahat olabilmek

- Temel istatistiksel analizleri veri ile yapabilmek

Tabii ki veri okuryazarlığının belirli yöntemleri var. Tanımı önemli ama diğer önemli tarafı da bu alanda çalışanların ve kendilerini geliştirenlerin yöntemlerinin neler olduğunu iyi anlamak. Herkesin kendini geliştirirken farklı yöntemleri ve teknikleri olduğu aşikar. Kimisi eğitimler, kimisi çevrim içi çalışmalar, kimisi uzun ve kısa atölyeler ile öğrenme ve uygulama yöntemleri geliştiriyor. Örneğin 2-5 gün arası yapılan atölyelerde proje yaparak çıkmış olmak bu alanda önemli bir yöntem olarak karşımıza çıkıyor. 2 saatlik atölyeler, yarım günlük atölyeler (örneğin veri gazeteciliği atölyeleri gibi ya da veri terapisi atölyeleri gibi) nitekim bazı derslerimde databasic.io ile öğrencilerin minik çalışmalar yapmalarını da sağladığım oluyor ve bu da veriyi kullanma, ondan yararlanma algısına çok basit ama çok hızlı bir şekilde yardımcı olabiliyor, 2 ya da 3 günlük atölyeler, 5 günlük atölyeler (veri boruhattı/data pipeline sürecinin tamamını uygulama gibi), 10 günlük atölyeler de ise rahatlıkla özgün proje üzerine konuşma, çalışma, araştırma ve araçları seçme gibi kapsamlı bir süreci kapsıyor.

Bu da veri okuryazarlığı sürecinde yöntem ve teknikleri geliştirmede önemli bir unsur oluyor. Bu durumu ben özellikle kendi atölyelerime katılan kişilerin her atölyeme tekrar tekrar gelmelerinden anlıyorum. Çünkü 1 ya da 2 günlük atölyede temel konuları alsa bile uygulama ve geliştirmede bir iki kez daha eğitim alma ihtiyacı duyabiliyor. Bunun yanında veri okuryazarlığı geliştirilebilir orta, uzun süreli eğitimlere katılmak yararlı olabiliyor. Örneğin 5 haftalık haberlab modeli bir eğitim, 4 haftalık bir eğitim modeli de olabilir. Ya da burslu programlar, araştırma programları, 6 aylık projelerde yer alarak da bu alanda gerçek bir kazanım elde edilebilir ve aynı zamanda çevrim içi ve çevrim dışıKitlesel Açık Çevrim içi Ders /Massive Open Online Couse (MOOC) eğitimlerine katılımlar da oldukça etkili oluyor. MOOC’a değinmişken bizim de Türkçesini yapacağımızın haberini vereyim buradan. Açık Veri ve Veri Gazeteciliği Derneği (AVVG/School of Data Turkey/SoDTurkey) olarak da kazandığımız bir fon ile 4 aylık bir veri okuryazarlığı, veri gazeteciliği ve açık veri eğitimi süreçlerini kapsayan detaylı bir proje hazırlığı içinde olacağız hazirandan itibaren. Bu da bu alanda Türkiye’de yapılacak olan ilk MOOC olacak, dili ve içerikleri de Türkçe olacak.

Veri okuryazarlığı alanında gelişebilmek ve yöntem oluşturmak esasen disiplinli çalışma, istek, azim ve tabii ki etkin kaynaklardan yararlanmayı da gerektiriyor. Şahsen ben tüm bu süreçte ve hâlâ en fazla yararlandığım bazı kaynakların yararını ciddi şekilde görüyorum. Örneğin, şu anda Türkçe’ye de çevirdiğimiz ama İngilizce’sine de ulaşılabilecek School of Data eğitim kaynaklarındanyararlanılabilinir, www.fabriders.net adresinden temel veri eğitimleri alınabilir, Global Editors Network iyi bir kaynak, poynter.org, medialab.sciences, dssg.uchicago, knightcenter ve veri gazeteciliği kursları www.verigazeteciligi.com, www.avvg.org.tr, www.datadrivenjournalism.net vb.

Tüm bu yöntemler ışığında veri okuryazarlığı çabalarını nasıl ölçebiliriz? Bize hangi çıktılar bu çabaların ya da çalışmaların sonuç verdiğini gösterir?

Veri analizlerinin çıktılarını gözlemlemek, doğrudan becerilerin gelişip gelişmediğini analiz etmek, bunlar bazı ölçümler olabiliyor. Şahsen atölye sonrası, ders sürecinde veri okuryazarlığı çabalarımın kısmen sonuç verdiğini tecrübe edebiliyorum. Verinin bir e-tabloya nasıl yerleştirebileceğini bilmeyen bir gazetecilik öğrencisi, dönemin sonunda özet tablolar, open refine ile verisini farklı veri formatlarını da analiz edip, temizleyip grup ya da solo projesinde kullanıyor, üstelik ilk haftalarda çok korktuğu bu ders, onun için keyf alınan, ‘koşarak gittiği’ bir alana dönüşüyor. Sonuçları bana da ulaşır ise mutlaka paylaşırım, Kadir Has Üniversitesi Halkla İlişkiler Bölümü öğrencisi ve aynı zamanda veri gazeteciliği dersimi de almış öğrencim Sadettin Demirel, ‘Türkiye’de Açık Veri ve Veri Gazeteciliği Atölyeleri Katılımcı Deneyimi ve Geri Bildirim Araştırması’ yapıyor, düzenlediğimiz 30’a yakın yarım gün ve 1-2-3 günlük atölyelere yönelik. Bu geri bildirimler bu alanda yapılan veri okuryazarlığı çabalarına da kısmen bir destek sunacaktır diye düşünüyorum.

Veri Gazeteciliği araçları neler? Bir veri en hızlı şekilde nasıl doğrulanır, denetlenir?

Aslında buna hangi yanıtı verirseniz verin doğru bir yanıtı olamayacağını baştan belirtmek isterim. Özellikle içinde bulunduğumuz teknolojik imkanları düşününce, her gün araçlara yenileri eklenirken. Bültenlerini takip ettiğim ve oldukça kıymetli işler de yapan Nathan Yau kendisine bu soru sorulduğunda şöyle yanıtlıyor; “Bu soruyu yanıtlamaktan çekiniyorum, benim için kriter hangi aracın benim işime yaradığı ve işimi kolaylaştırdığı, benim için kullanımı kolay olan, bir başkası için en iyi olmayabilir” der. Bu açıklama üzerinden kendi düşüncemle devam edersem araçlar çok ama derslerimde en az araçtan bahsediyor, en fazla o aracı kullanmanın haberin formunda nasıl değişiklikler yaratabildiğine dikkat çekerek, öğrencilerin ya da katılımcıların o çok heyecan verici araçların büyüsüne kapılarak temel motivasyondan uzaklaşmasını önlemeye çalışıyorum. Bu sebeple her veri gazetecisi haritalama, analiz, görseleştirme vb. çalışma disiplininde kendisine en uygun araç ile çalışır ve bu dünyanın her noktasında da aynıdır. New York Times Upshop ekibi kendisi için en uygun, rahat araçla çalışır iken, siz başka bir aracı seçersiniz. Bu sebeple araçlar önemli ama daha önemli olan onların bizim işimizi nasıl kolaylaştırdığının farkına varabilmek. Yine de araçları aktarmamı ve tanıtmamı isterseniz buradan yüzlerde araca ulaşılabilir. Ancak atölyelerimde özellikle birkaç aracı kullanım için öneriyorum: Tabula, Open Refine, Libre Office, ilerisi için ilgilenenler için R ve web tabanlı e-tablolar.

Türkiye’de birçok kurum yaptıkları araştırmaları -bilinçli olarak- kendileri kullandıktan sonra dahi kamuyla paylaşmıyor. Kamu yararı ve veri ilişkisine bu açıdan baktığınızda bu verilere ulaşmayı kolaylaştıracak neler yapılabilir?

Esasen herkes her şeyini açmak zorunda değil. Araştırmaların herkese açılması mecburidir diye bir durum yok ancak siz bir sivil toplum kuruluşu iseniz, belediyeyseniz, araştırma kurumuysanız ve yaptığınız çalışmalardan başkalarının da yararlanmasını ve değer yaratmasını istiyorsanız onları ulaşılır yapmanız önemli, ayrıca sadece ulaşılır olması da yeterli olmuyor, araştırmanın ve verinin formatı da önem kazanıyor. Açık Veri Endeksi’nin kriterlerini incelediğimizde de görüyoruz verinin formatı, açık lisanslı olması, herkesin yararlanabilmesinin sağlanması da kriterler arasına alıyor. Veriler dijitalde konuşabildiğinde değer yaratma olanağı da artıyor. Veriden değer yaratmak, erişime açtığınızda ‘elektrik, su, yol’ olarak geri dönüyor.

Neler yapılabilir sorusuna gelecek olursam; düzenli olarak açık veri çalıştayları yapılmalı tüm politika yapıcılarla. Veri ile çalışma disiplinine ağırlık veren bir politika izlenmeli, devletin açık veri ve açık yönetim politikasını sembolik olmaktan çıkarıp, hayata geçirmesi önemli bir adım, büyük veri teknolojilerini sadece konuşan değil, anlayabilen bir nesilin de oluşmasına katkı sunabilmek. Üniversitelerin, meslek örgütlerinin, STK’ların açıklık, şeffaflık, değer yaratmak konularını toplumun neden ihtiyacı olduğunu yılmadan izah etmesi ve uygulamaya geçirmesi hiç olmadığı kadar önemli bu bağlamda. Şunu da belirtmek isterim, aksilik olmaz ise Türkiye’nin ilk Ulusal Açık Veri Kongresi’ni düzenleyeceğiz sonbaharda Açık Veri ve Veri Gazeteciliği Derneği olarak. Bu kongrenin hedefi ise yukarıda bahsettiğim iklimin gelişmesine katkı sağlamak.

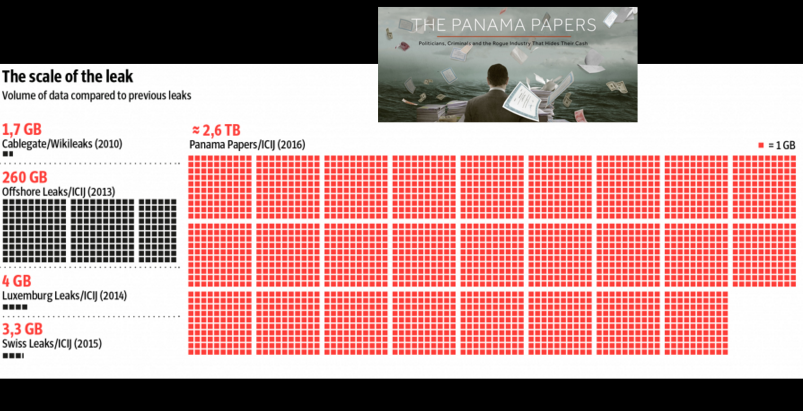

Dünya geçen haftalarda gazetecilik tarihinin en büyük veri sızıntısı olarak kabul edilen, Uluslararası Araştırmacı Gazeteciler Konsorsiyumu’nun ortaya çıkardığı Panama belgeleri ile çalkalandı. Belgelerin haberleştirilmesi için 400’e yakın gazetecinin çalıştığını biliyoruz. 2.6 terabayt büyüklüğündeki 11.5 milyon belgelik bir veri nasıl haberleştirilir?

Bu örnek üzerinden gidersek, sizin tek başınıza yapabileceğiniz bir şey değil ancak hep şöyle denir, “büyük veriyi anlamak için önce küçükten başlamak gerekir.” Önünüze bir sızıntı gelmiş ise sorunları çözme yeteneği olan ve tabii buna da gönüllü olan bir ekiple bir ucundan işe başlamak gerekiyor. Bazen paraşütle konunun içine de dalmanız gerekebilir. Teknoloji, içerikleri analiz edip bilgiyi arama, haber değeri çıkarma süreci tabii ki meşakkatli. Panama Belgeleri açısından bakarsak sızan veriler herkesin erişimine açılır ise haberciler kendi ülkeleri, liderleri, şirketleri üzerinden yerel odaklı verilere odaklanarak rahatlıkla bu sızan verilerden yararlanabilirler. Veriye ulaşmak önemli ama en önemlisi kullanabilme, yani yine veri okuryazarlığı yeteneklerini geliştirmiş olma önemlilik kazanıyor. Şahsen, Uluslararası Araştırmacı Gazeteciler Konsorsiyumu ile birlikte Türkiye ayağında çalışmak için başvurmuş olmama rağmen yanıt alamasam da, veriler bana da önceden gelmiş olsaydı, inanıyorum ki bir ekip kurarak bir yerinden mutlaka çalışma yürütebilirdim ve hâlâ da yürütebileceğime inanıyorum, nereden başlayabileceğime yönelik fikrim olduğunu düşünüyorum. Tabii ki pahalı bir süreç ama yine de yapılabilir.

“Büyük Veri Sızıntıları ile İlgili Ne Yapmalıyız?” çevirisinin bir bölümünü buraya da eklemek istiyorum, yazar Paul Ford şöyle diyor, “#panamapapers … Panama verileriyle iki heyecan verici şeyle tanıştık: İlk olarak, medya kuruluşlarının bir konsorsiyum ile bir araya gelip sızıntıyı kolektif bir biçimde ele alması ve hashtagler (#panamapapers) vasıtasıyla İnternet’te insanları haberdar etmesi; ikinci olarak ise, sızıntının içeriğinin ne olduğunu anlamak güç olmasına rağmen dosya boyutunu 2.5 terabaytı bulması bir başka ilgi çekici konu teşkil ediyor. Bu sızıntıyla ilgilenen gazeteci konsorsiyumu The New York Times, The Washington Post vb. gibi büyük gazeteleri içermiyor. Gelişmeleri takip etmeye devam ediyoruz fakat mesele olduğu gibi duruyor: Bu yapay olgular gayretli amatörler için ulaşılabilir değil. Bir diğer deyişle, bir hayli para ve zaman gerektirdiğinden, bu verileri anlamak yalnızca profesyonellerin ihtisas alanı olarak kalmakta.” Bütçenizin olması da yeterli gözükmüyor, size yardımcı olabilecek uzman kişilerin olması, bir ekip çalışması ile iyi bir sistem kurmanız gerekiyor, bu sebepledir ki her gün veri çağına uyum geçişinin çıtasını arttırmak için yeni araçlar ve teknolojiler geliştiriliyor.

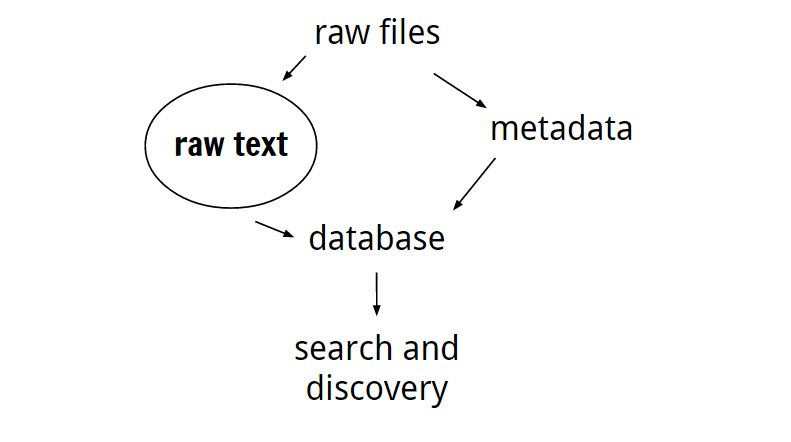

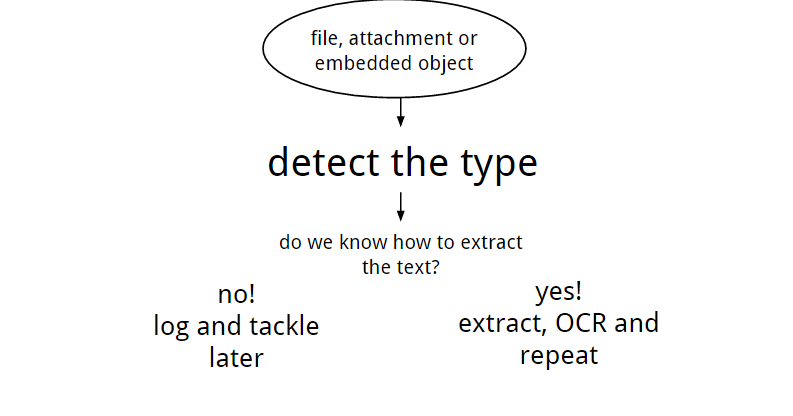

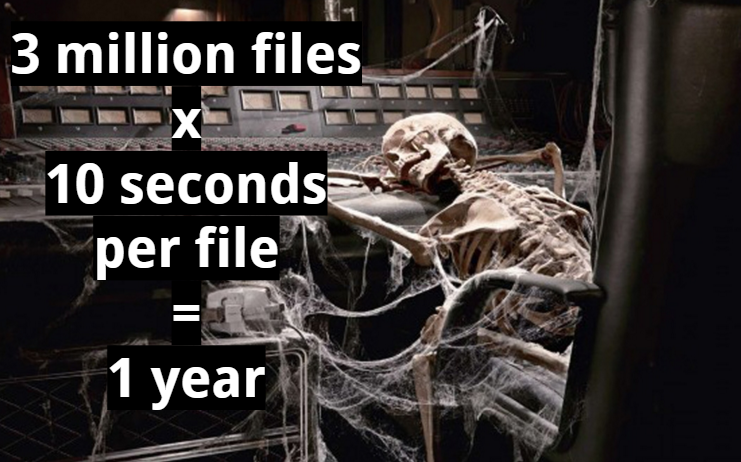

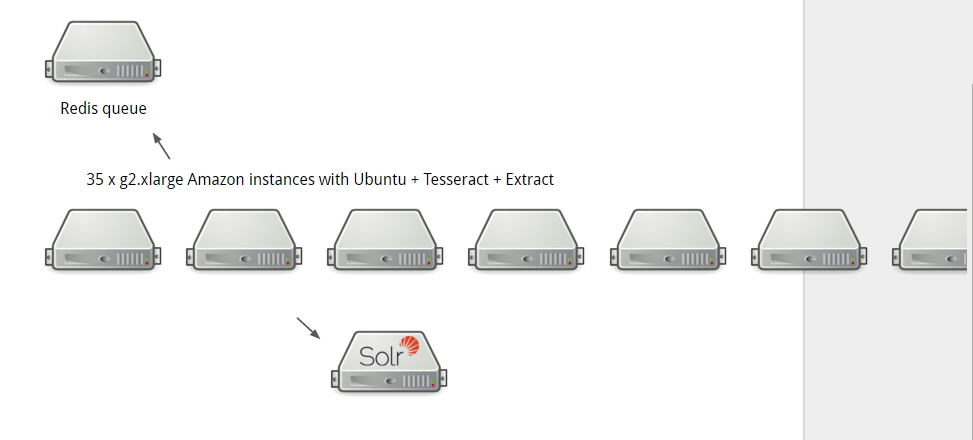

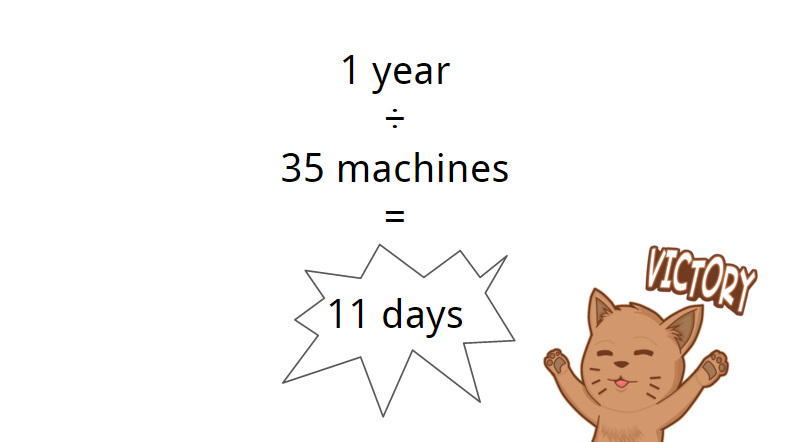

Mar Cabra’nın paylaştığı sunuma buradan ulaşabilirsiniz. Sunumda da görüyorsunuz ki çalışma süresince çeşitli araçlar, teknolojiler, insan kaynağı, çalışma teknikleri ve daha birçok detay veriliyor Panama Belgeleri ile ilgili yürütülen 1 yıllık çalışmada. 40 yıllık bir süreci kapsayan veri sızıntısını analiz edip, içinden bilgi çıkarıp, ‘kamuyu aydınlatmak’, destek, bütçe, uzmanlık ve daha pek çok hizmetle mümkün olabiliyor. Ancak şunu da bilmekte fayda var, henüz verilerin bir kısmını görebildik. Mayıs ayının ilk haftası konsorsiyum tarafından ilgili şirketlerin de açıklanacağını biliyoruz. (Panama Belgeleri 9 Mayıs’ta içinde arama yapılabilir bir veri tabanı halinde yayınlanacak.)

Sunumdan bazı bölümler:

Bugüne kadar yapılan sızdırmalarda çoğunlukla Wikileaks’in hakimiyetinden söz ediyorduk. Fakat bu sefer farklı bir kaynak söz konusu. Sizce bu denli büyük bir verinin tüm dünyaya fayda sağlayacak şekilde yorumlanması mümkün olacak mı? Yoksa bu durumdan çıkar sahibiçevreler mi yararlanacak?

Herkese hem yarıyor hem yaramıyor. Veri gazeteciliğinde şöyle bir ifade var: “Nasıl kimsenin canını yakmadan, veri ile etkin çalışma yürütürüm.” Aslında bununla kast edilen verinin manipülasyona açıklığı, sizin isteyerek ve istemeyerek birilerini doğrudan ve dolaylı zor duruma sokma ihtimaliniz. Temel haber prensibinde olduğu gibi etik davranma konusu önem kazanıyor.

Uluslararası finans dünyasının arka planda neler yaptığının küçük bir bölümünü gördüğümüz bu sızıntılar gazetecilere, ilgili herkese tam olarak açık olmaya başladığında bu soruya daha net bir yanıt verilebilir sanırım. Faydasını hemen ölçmek mümkün gözükmese de bazı istifaların olması, bazı ülkelerin soruşturma başlatması önemliydi. Ayrıca 9 Mayıs’ta ifade edilen şirket ve şahıs isimleri de yayımlandığında küresel ölçekte etkilerini daha net görebileceğiz diye düşünüyorum.

Pınar Dağ kimdir?

Veri Gazetecisi (www.verigazeteciligi.com), Dijital Yayıncı (Dağ Medya), Kıdemli Araştırmacı (GrassrootSM Research), Öğretim Üyesi (Khas /Arel), Açık Veri ve Veri Gazeteciliği Derneği Başkanı (avvg.org.tr)

Geri bildirim: AVVG, 4 Ayı Kapsayan Veri Okuryazarlığı Projesine Başlıyor | Dağ Medya

Geri bildirim: 12 Ekim|Arel Üniversitesi Öğrencilerine Veri Okuryazarlığı Atölyesi – Açık Veri ve Veri Gazeteciliği